ChatGPT چیست؟

OpenAI یک هوش مصنوعی پاسخگوی سوال طولانی به نام ChatGPT معرفی کرد که به سوالات پیچیده به صورت مکالمه پاسخ می دهد.

این یک فناوری انقلابی است، زیرا آموزش داده شده است تا بفهمد انسان هنگام پرسیدن سوال دقیق چه منظوری دارد.

بسیاری از کاربران از توانایی آن در ارائه پاسخ های با کیفیت انسانی شگفت زده شده اند و این احساس را القا می کند که ممکن است در نهایت این قدرت را داشته باشد که نحوه تعامل انسان ها با رایانه ها را مختل کند و نحوه بازیابی اطلاعات را تغییر دهد.

ChatGPT چیست؟

اما سوال اصلی این است که اصلا ChatGPT چیست؟

ChatGPT یک چت بات مدل large language است که توسط OpenAI بر اساس GPT-3.5 توسعه یافته است. توانایی قابل توجهی در تعامل در قالب گفتگوی محاوره ای و ارائه پاسخ هایی دارد که می تواند به طرز شگفت آوری انسانی به نظر برسد.

مدل های large language وظیفه پیش بینی کلمه بعدی را در یک سری کلمات انجام می دهند.

Reinforcement Learning with Human Feedback (RLHF) یا یادگیری تقویتی با بازخورد انسانی یک لایه آموزشی اضافی است که از بازخورد انسانی برای کمک به ChatGPT برای یادگیری توانایی پیروی از دستورالعملها و ایجاد پاسخهای رضایتبخش برای انسان استفاده میکند.

چه کسی ChatGPT را ساخت؟

ChatGPT توسط شرکت هوش مصنوعی OpenAI مستقر در سانفرانسیسکو OpenAI Inc ایجاد شده است.

OpenAI به دلیل DALL·E معروف خود، یک مدل یادگیری عمیق که تصاویر را از دستورالعمل های متنی به نام prompt تولید می کند، مشهور است.

مدیرعامل این شرکت سام آلتمن است که قبلاً رئیس Y Combinator بود.

مایکروسافت شریک و سرمایه گذار به مبلغ 1 میلیارد دلار است. آنها به طور مشترک پلتفرم هوش مصنوعی Azure را توسعه دادند.

مدل های زبان بزرگ:

ChatGPT یک مدل زبان بزرگ (LLM) است. مدلهای زبان بزرگ با مقادیر انبوهی از دادهها آموزش داده میشوند تا دقیقاً پیشبینی کنند چه کلمهای در یک جمله قرار میگیرد.

مشخص شد که افزایش مقدار داده، توانایی مدل های زبان را برای انجام کارهای بیشتر افزایش می دهد.

LLM ها کلمه بعدی را در یک سری از کلمات در یک جمله و جملات بعدی را پیش بینی می کنند ؛ به نوعی مانند تکمیل خودکار، اما در مقیاسی که ذهن را شگفت زده می کند.

این توانایی به آنها اجازه می دهد پاراگراف ها و کل صفحات محتوا را بنویسند.

اما LLMها از این جهت محدود هستند که همیشه نمی دانند یک انسان دقیقاً چه می خواهد.

و اینجاست که ChatGPT با آموزش یادگیری تقویتی با بازخورد انسانی (RLHF) پیشرفت می کند.

ChatGPT چگونه آموزش داده شده است؟

GPT-3.5 بر روی حجم عظیمی از دادهها در مورد کد و اطلاعات از اینترنت، از جمله منابعی مانند بحثهای Reddit، آموزش داده شد تا به ChatGPT در یادگیری گفتگو و دستیابی به سبک انسانی پاسخدهی کمک کند.

ChatGPT همچنین با استفاده از بازخورد انسانی (تکنیکی به نام یادگیری تقویتی با بازخورد انسانی) آموزش داده شد تا هوش مصنوعی متوجه شود که انسان ها هنگام پرسیدن سوال چه انتظاراتی دارند. آموزش LLM یک روش انقلابی است زیرا فراتر از آموزش ساده LLM برای پیش بینی کلمه بعدی است.

یک مقاله تحقیقاتی در مارس 2022 با عنوان مدلهای زبان آموزشی برای پیروی از دستورالعملها با بازخورد انسانی توضیح میدهد که چرا این یک رویکرد پیشرفت است:

”انگیزه این کار با هدف ما افزایش تأثیر مثبت مدلهای زبانی بزرگ با آموزش آنها برای انجام کاری است که مجموعهای از انسانها میخواهند انجام دهند.

بهطور پیشفرض، مدلهای زبان هدف پیشبینی کلمه بعدی را بهینه میکنند، که تنها یک پروکسی برای کاری است که ما میخواهیم این مدلها انجام دهند.

نتایج ما نشان میدهد که تکنیکهای ما برای مفیدتر، صادقتر و بیضررتر کردن مدلهای زبانی نویدبخش است.

بزرگتر کردن مدلهای زبان ذاتاً آنها را در پیروی از هدف کاربر بهتر نمیکند.

برای مثال، مدلهای زبان بزرگ میتوانند خروجیهایی تولید کنند که غیرواقعی، مسخره یا به سادگی برای کاربر مفید نباشند.

به عبارت دیگر، این مدل ها با کاربران خود هماهنگ نیستند.“

مهندسانی که ChatGPT را ساختند، پیمانکارانی (به نام labelers) استخدام کردند تا خروجیهای دو سیستم GPT-3 و InstructGPT جدید (یک «مدل خواهر و برادر» ChatGPT) را رتبهبندی کنند.

بر اساس رتبه بندی، محققان به نتایج زیر رسیدند:

”به طور کلی، نتایج ما نشان میدهد که تنظیم دقیق مدلهای زبان بزرگ با استفاده از ترجیحات انسانی به طور قابلتوجهی رفتار آنها را در طیف وسیعی از وظایف بهبود میبخشد، اگرچه کارهای زیادی برای بهبود ایمنی و قابلیت اطمینان آنها باقی مانده است.“

چیزی که ChatGPT را از یک چت بات ساده متمایز می کند این است که به طور خاص برای درک مقصود انسان در یک سوال و ارائه پاسخ های مفید، واقعی و بی ضرر آموزش داده شده است.

به دلیل آن آموزش، ChatGPT ممکن است سؤالات خاصی را به چالش بکشد و بخشهایی از سؤال را که منطقی نیستند کنار بگذارد.

مقاله تحقیقاتی دیگری مربوط به ChatGPT نشان می دهد که چگونه آنها هوش مصنوعی را برای پیش بینی آنچه که انسان ترجیح می دهند آموزش دادند.

محققان متوجه شدند که معیارهای مورد استفاده برای رتبهبندی خروجیهای پردازش زبان طبیعی هوش مصنوعی به ماشینهایی منجر میشود که امتیاز خوبی در این معیارها کسب میکنند، اما با آنچه انسانها انتظار داشتند همسو نمیشوند.

روشی که محققان این مشکل را توضیح داده اند به شرح زیر است:

”بسیاری از برنامه های کاربردی یادگیری ماشین معیارهای ساده ای را بهینه می کنند که تنها پروکسی های تقریبی برای آنچه طراح در نظر دارد است. این میتواند منجر به مشکلاتی شود، مانند توصیههای YouTube برای ترویج کلیک بیت.“

بنابراین راه حلی که آنها طراحی کردند، ایجاد یک هوش مصنوعی بود که بتواند پاسخ هایی بهینه سازی شده برای آنچه که انسان ها ترجیح می دهند، ارائه دهد.

برای انجام این کار، آنها هوش مصنوعی را با استفاده از مجموعه دادههای مقایسههای انسانی بین پاسخهای مختلف آموزش دادند تا دستگاه در پیشبینی پاسخهای رضایتبخش از نظر انسانها بهتر عمل کند.

این مقاله به اشتراک میگذارد که آموزش با خلاصه کردن پستهای Reddit و همچنین آزمایش بر روی خلاصهسازی اخبار انجام شده است.

مقاله پژوهشی فوریه 2022 یادگیری خلاصه کردن از بازخورد انسانی نام دارد.

محققان می نویسند:

”در این کار، ما نشان میدهیم که میتوان با آموزش مدلی برای بهینهسازی برای ترجیحات انسانی، کیفیت خلاصه را به طور قابل توجهی بهبود بخشید.

ما یک مجموعه داده بزرگ و با کیفیت از مقایسههای انسانی بین خلاصهها جمعآوری میکنیم، مدلی را برای پیشبینی خلاصه ترجیحی انسان آموزش میدهیم و از آن مدل به عنوان تابع برای تنظیم دقیق سیاست خلاصهسازی با استفاده از یادگیری تقویتی استفاده میکنیم.“

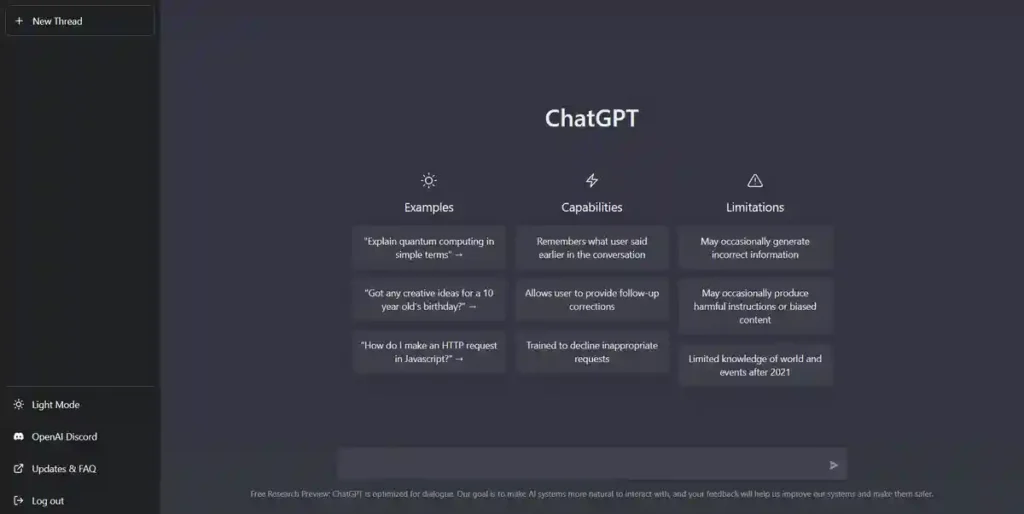

محدودیت های ChatGPT چیست؟

- محدودیت در واکنش های آزاردهنده

ChatGPT به طور خاص برنامه ریزی شده است تا پاسخ های سمی یا مضر ارائه نکند. بنابراین از پاسخ دادن به این نوع سوالات اجتناب خواهد کرد.

- کیفیت پاسخ ها به کیفیت دستورالعمل ها بستگی دارد

یک محدودیت مهم ChatGPT این است که کیفیت خروجی به کیفیت ورودی بستگی دارد. به عبارت دیگر، دستورالعمل های متخصص (اعلانات) پاسخ های بهتری را ایجاد می کنند.

- پاسخ ها همیشه صحیح نیستند

محدودیت دیگر این است که چون آموزش داده شده است تا پاسخ هایی را ارائه دهد که برای انسان ها درست باشد، پاسخ ها می توانند انسان را فریب دهند که خروجی درست است.

بسیاری از کاربران متوجه شدند که ChatGPT می تواند پاسخ های نادرستی ارائه دهد، از جمله برخی از آنها که به شدت نادرست هستند.

ناظران در وبسایت پرسش و پاسخ برنامهنویسی Stack Overflow ممکن است پیامدهای ناخواستهای از پاسخهایی که برای انسانها مناسب است، کشف کرده باشند.

Stack Overflow مملو از پاسخهای کاربران ایجاد شده از ChatGPT بود که به نظر درست میرسیدند، اما تعداد زیادی پاسخ اشتباه بودند.

هزاران پاسخ تیم ناظر داوطلب را تحت تأثیر قرار داد و مدیران را بر آن داشت تا برای هر کاربری که پاسخهای ایجاد شده از ChatGPT را ارسال میکنند، ممنوعیتی وضع کنند.

سیل پاسخ های ChatGPT منجر به پستی شد با عنوان Temporary policy: ChatGPT is banned:

«این یک سیاست موقت است که هدف آن کاهش هجوم پاسخها و سایر محتوای ایجاد شده با ChatGPT است.

… مشکل اصلی این است که در حالی که پاسخ هایی که ChatGPT تولید می کند دارای نرخ بالایی از نادرست بودن هستند، آنها معمولاً به نظر می رسند که ممکن است درست باشند…»

تجربه گردانندگان Stack Overflow با پاسخهای اشتباه ChatGPT که درست به نظر میرسند، چیزی است که OpenAI، سازندگان ChatGPT، از آن آگاه هستند و در اطلاعیهشان از فناوری جدید به آن هشدار دادهاند.

دیدگاهتان را بنویسید