امروز بالاخره MI300X منتشر شد و با صدای بلند منتشر شد. مشتریان زیادی اعلام شدهاند که در اینجا درباره حجم و ASP آن صحبت کردیم، از جمله افرادی مانند اوراکل، متا و مایکروسافت. ما پیکربندی و معماری را در ماه ژوئن ارسال کردیم، بنابراین در حالی که جزئیات معماری سطح پایین جدیدی در پایان این امروز وجود دارد، ما بیشتر روی عملکرد، هزینه و نرم افزار تمرکز خواهیم کرد. همچنین خبرهای بزرگ در مورد اتحاد ضد انویدیا AMD + Broadcom.

در مشخصات خام، MI300X با 30 درصد FP8 FLOPS بیشتر، 60 درصد پهنای باند حافظه بیشتر و بیش از 2 برابر ظرفیت حافظه بر H100 غالب است. البته MI300X در مقابل H200 فروش بیشتری دارد که شکاف پهنای باند حافظه را به محدوده تک رقمی و ظرفیت به کمتر از 40 درصد کاهش می دهد. متأسفانه MI300X تنها توانست به 5.3 ترابایت بر ثانیه پهنای باند حافظه را به جای 5.6 ترابایت بر ثانیه که در ابتدا هدف گذاری شده بود، برساند.

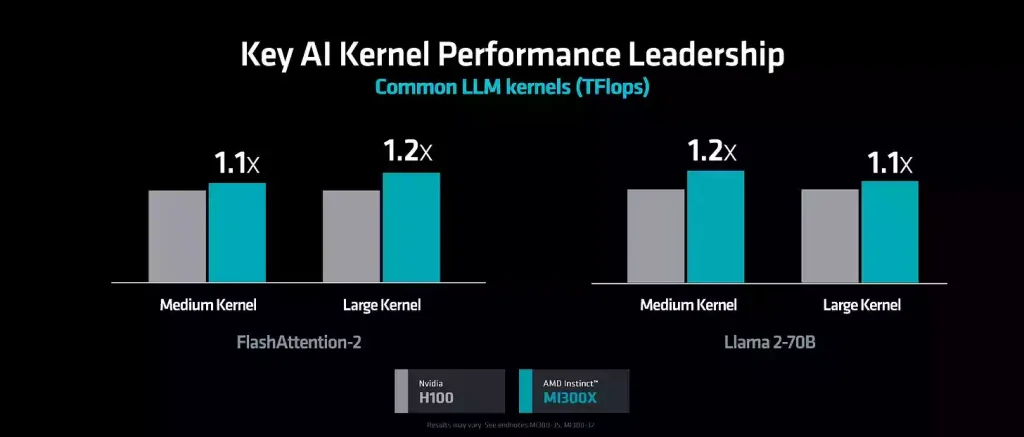

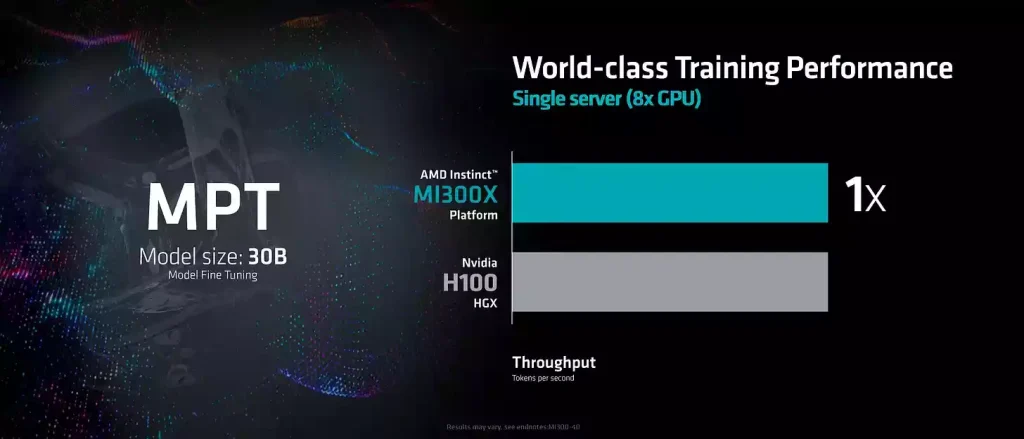

البته FLOPS، ظرفیت و پهنای باند فقط قابلیتهای بالقوه هستند. AMD چند بنچمارک مختلف را نشان داد، موضوع اصلی این است که آنها هنوز در مقایسه با عملکرد تئوری کمی پایینتر هستند.

FlashAttention2 – این فقط پاس رو به جلو است، استنتاج IE، نه آموزش. قابل توجه است زیرا تقریباً هر بنچمارکی که AMD به اشتراک میگذارد فقط پاس رو به جلو بود. مزیت عملکرد 10٪ تا 20٪ است، بسیار کمتر از مشخصات خام.

LLAMA2-70B – باز هم پاس رو به جلو فقط برای کرنل های خاص، نه مدل کامل، و دوباره 10% تا 20% عملکرد. اینها بیشتر بارهای کاری محدود به محاسبه هستند، نه محدود به حافظه.

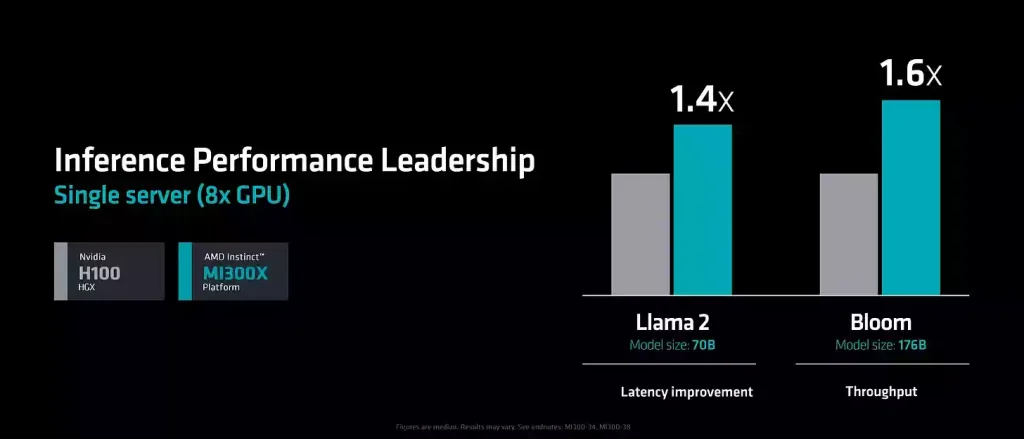

استنتاج از سوی دیگر، AMD دو معیار استنتاج متفاوت را نشان داد، یکی اندازه و توان عملیاتی بالا و دیگری کمترین تأخیر ممکن بود.

بلوم – این معیار از همه آنها چشمگیرتر است، اما ما فکر می کنیم یکی از ترفندهای کلاسیکی است که دیده ایم شرکت های دیگر در هنگام داشتن مزیت ظرفیت حافظه انجام می دهند. از مدلی استفاده کنید که به سختی در سیستم استنتاج قرار می گیرد، در این مورد، بلوم کمی بیش از 350 گیگابایت حافظه 640 گیگابایتی که H100 HGX دارد، می گیرد. سپس از طول توالی ورودی بسیار بزرگ (در این مورد 2k) نسبت به تعداد توکن خروجی (100) استفاده می کنید. سیستمی که حجم حافظه کمتری دارد، مجبور می شود با حجم بسیار کمتری اجرا شود زیرا KVCache تمام ظرفیت حافظه را اشغال می کند. در همین حال، AMD می تواند از یک اندازه بزرگتر برای استفاده از محاسبات خود استفاده کند. برای روشن بودن، این یک مزیت واقعی است و سناریوی متمرکز بر توان عملیاتی واقعی است.

LLAMA 2-70B – این یک معیار استنتاج واقعی تر برای اکثر موارد استفاده است. AMD دارای 40٪ مزیت تاخیر است که با توجه به مزیت پهنای باند 60٪ در مقایسه با H100 بسیار منطقی است. با توجه به اینکه H200 از نظر پهنای باند بسیار نزدیکتر است، انتظار داریم عملکرد مشابهی داشته باشد. توجه داشته باشید که AMD از VLLM برای انویدیا استفاده کرده است که بهترین پشته باز برای توان پردازشی است، اما منبع بسته TensorRT LLM انویدیا به همان اندازه آسان برای استفاده است و تا حدودی تاخیر بهتری در H100 دارد.

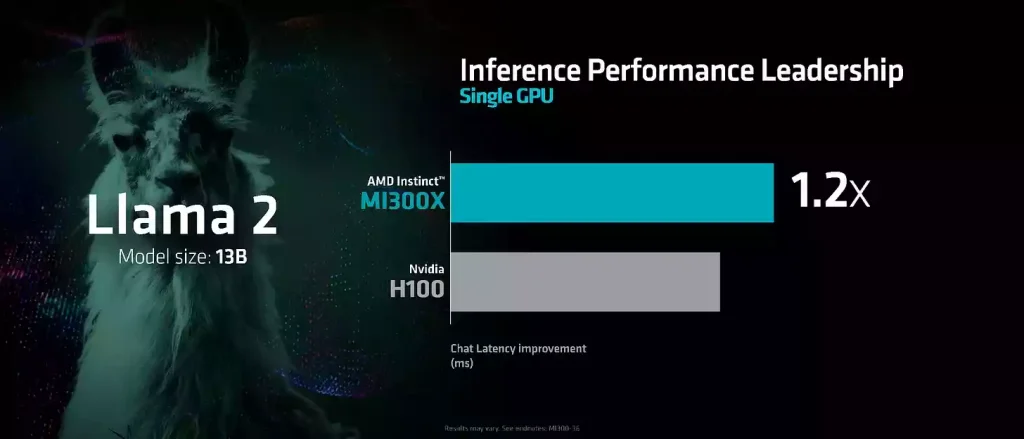

آخرین معیار LLAMA 2 -13B است. بهبود عملکرد در اینجا 20٪ است، در اینجا چیز زیادی نمی توان به آن اشاره کرد. MI300X ارزان تر است. H200 احتمالاً شکاف را می بندد.

AMD در اینجا کمی ضعف در بخش نرم افزاری خود نشان می دهد. آنها تنها کمتر از 30 درصد از FLOPS های نظری را که MI300 توانایی دارد، به دست می آورند. در همین حال انویدیا اغلب به 40 درصد می رسد. به طوری که چنین عملکردی وجود ندارد.

عملکرد آنها به چند دلیل با Nvidia مطابقت دارد. یکی از دلایل اصلی این است که AMD فقط نیمی از FLOPS نظری را در بارهای کاری خام GEMM دریافت می کند. مورد دیگر این است که FlashAttention2 هنوز روی پاس به عقب به خوبی کار نمی کند. حافظه نهان L1 AMD دو برابر شده است، اما LDS هنوز هم اندازه است. کار کردن FA2 در مقابل حافظه مشترک بزرگتر انویدیا همچنان سخت تر است.

در طول زمان، ما انتظار داریم که این به طور معناداری بهبود یابد. این نقطه روشن بزرگ برای این اعداد است، ما شاهد بهبود سریع AMD هستیم.

به طور کلی، ما شاهد بهبود عملکرد تریتون هستیم، به خصوص برای GEMM خام.

این یک معامله بزرگ است زیرا OpenAI و مایکروسافت به شدت از AMD MI300 برای استنتاج استفاده خواهند کرد.

همچنین، برای روشن بودن حالت اشتیاق و torch.compile فقط برای اکثر مدلها در آموزش، تنظیم دقیق و استنتاج برای اکثر مدلهای موجود کار میکنند، اما چیزی که کمبود دارد بهینهسازی عملکرد است. ما شاهد وقوع آن هستیم.

دیدگاهتان را بنویسید